联络中心和客户体验领域已进入快速发展和创新的时期,这在很大程度上是由人工智能创新驱动的。从生成式人工智能聊天机器人到高级语音分析工具,先进的人工智能解决方案正在改变公司和客户的互动方式。

如果使用得当,人工智能能够降低运营成本,提高座席人员的工作效率,甚至通过更加个性化、数据驱动的支持来增强客户服务。不幸的是,联络中心的人工智能也有其阴暗面。

正如公司可以使用人工智能生成内容和调用脚本一样,不良行为者也可以利用相同的工具进行欺诈并窃取私人信息。 Deepfakes 是为了合成和复制人声而创建的,可以相对轻松地欺骗 IVR 系统和传统的身份验证方法。

这个问题变得越来越明显,以至于OpenAI 甚至停止了其语音克隆工具的发布,并建议联络中心逐步淘汰基于语音的身份验证作为安全措施。那么,深度造假的威胁到底有多大,您的公司可以采取什么措施呢?

联络中心中不断演变的 Deepfake 威胁

人工智能日益强大的力量引起了客户、监管机构和公司等越来越多的关注。自从生成式人工智能成为人们关注的焦点以来,深度造假的概念就变得更加普遍。

最初,消费者将“深度伪造”与伪造的名人照片和视频联系在一起。然而,现在,我们看到越来越多的证据表明人工智能也可以用来合成人的声音,其准确度令人震惊。 OpenAI 不仅计划发布专门为此目的设计的解决方案,而且许多其他组织也一直在尝试对话式 AI 机器人,这些机器人可以代表客户与联络中心进行交互。

虽然这对于想要避免长时间呼叫队列和对话的客户来说似乎是一件好事,但对于联络中心来说这是一个严重的担忧,并且直接违背了“道德人工智能”的概念,为犯罪分子使用新方法打开了大门人工智能伤害消费者。

如果消费者可以使用机器人来复制他们的声音,那么就没有什么可以阻止犯罪分子做同样的事情。虽然人工智能道德标准(例如 OpenAI)的追随者可以发布声明强调其工具的危险性,但企业领导者和联络中心应该主动应对威胁。首先要了解深度造假欺诈中出现的模式。

“随着 Deepfake 威胁的出现,保护客户数据和信任对于联络中心来说至关重要。通过优先考虑道德人工智能实践和严格的安全协议,企业可以推动创新,同时保护客户体验和声誉。” – MaxContact 首席执行官 Ben Booth

不良行为者如何在联络中心使用 Deepfakes

虽然人工智能驱动的语音身份验证工具可以简化联络中心验证客户的过程,但许多工具很难区分真实的“现场”人类声音和经过训练以复制人的声音的机器人。Pindrop 最近发布了一份报告,强调了不良行为者已经在联络中心使用深度伪造的多种方式。例如,不良行为者是:

- 使用合成语音绕过 IVR 身份验证:借助高度准确的机器生成的语音,绕过自动IVR身份验证系统相对容易,特别是在犯罪分子已经知道用户安全问题的答案的情况下。在犯罪分子接管之前,机器人可以根据财务和余额查询快速确定哪些账户值得攻击。

- 利用人工智能更改个人资料数据:犯罪分子还可以使用合成声音提交请求,要求更改其个人资料数据,例如电子邮件地址或首选电话号码。当不良行为者想要从公司接收一次性密码或要求将新银行卡发送到更新的地址时,这通常是他们采取的第一步。

- 模仿银行 IVR:利用智能工具,犯罪分子可以教机器人模仿银行 IVR,让它们呼叫联络中心以收集有关所使用提示的数据。这本质上为犯罪分子提供了一种创建听起来高度准确的电话系统的方法,旨在诱骗客户共享有价值的数据。

- 收集有价值的数据:值得注意的是,合成语音并不总是专门用于绕过身份验证方法。许多欺诈者可能会使用合成语音来收集有关帐户的数据,了解 IVR 系统的工作原理,并收集他们所需的见解以进一步欺骗毫无戒心的客户。

联络中心如何做好准备?

不幸的事实是,深度伪造已经存在,对联络中心及其客户构成了重大威胁。企业领导者不能简单地等待人工智能创新者遵守人工智能道德准则,或者自己检测犯罪用户。当今的联络中心需要确保其身份验证系统做好防御深度伪造的准备。

对于许多联络中心来说,成功之路始于使用符合道德的人工智能实践。投资于道德人工智能策略的联络中心与供应商合作,确保数据安全存储和正确使用,他们还定期审查其人工智能策略,以保护消费者。

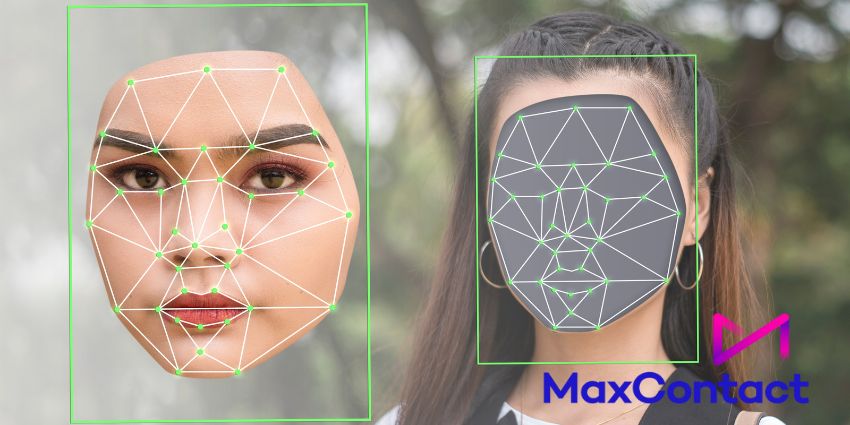

尽管人工智能可能是造成 Deepfake 问题的原因,但它也可以帮助提供解决方案。使用人工智能的创新语音分析工具不仅仅是将语音与录音进行匹配。他们可以检查情绪,并确定现场语音和录制语音之间的差异。MaxContact 的语音分析解决方案甚至可以根据客户的语言、语气和用词实时检测“弱势”客户。

除了以毒攻毒之外,通过使用人工智能来检测潜在的欺诈呼叫,联络中心还可以实施更强大的分层安全计划,使用以下策略:

坐席教育

联络中心始终需要人工座席。它们不仅在对话中提供同理心、创造力和同情心,而且在区分假声和真人声音方面比机器人更有效。指导员工如何检测合成声音,并指导他们在检测到问题时可以采取哪些措施至关重要。

值得注意的是,提供语音分析工具来帮助代理进行合成语音检测也很有用,可以让他们实时洞察情绪和脆弱性。

使用回调

如果呼叫者的声音听起来可疑,或者公司的报告和分析工具在对话过程中标记出不一致的地方,则进行回电可以帮助减轻威胁。它使客服人员有机会结束通话,然后使用他们已记录的联系方式与客户联系,以确保他们实际上正在与帐户所有者交谈。

不断记录联络中心数据并实时跟踪潜在“风险”客户的证据应有助于座席确定何时需要回电。

高级多重身份验证

尽管深度伪造有可能绕过多因素身份验证解决方案,但绕过各种不同的身份验证方法通常要困难得多。不要仅仅根据声音来评估客户,而是使用一次性密码,结合按键分析进行行为检测,或数字音调分析进行设备检测。

全面的多因素身份验证过程使用各种因素来确定身份验证资格,这将减少深度伪造带来的风险。

“深度伪造的兴起带来了严重威胁,但语音分析为联络中心提供了强大的对策。通过分析声音模式、情绪线索和生物识别,这些人工智能驱动的解决方案可以区分合成声音和真实客户的声音。随着 Deepfake 功能的发展,投资语音分析对于保护客户和减少欺诈变得至关重要。” – MaxContact 工程副总裁 Matthew Yates。

Deepfakes 来了:你准备好了吗?

不幸的是,机器人复制人类进行欺诈行为的想法不再只是一个未来的概念,而是一个现实。犯罪分子已经在利用生成式人工智能工具来合成人类声音、绕过 IVR 系统,甚至欺骗客户和现场客服人员。

为了在这种情况下保持安全,联络中心需要采用道德人工智能策略,以及全面、多方面的客户身份验证方法。如果不这样做,您的公司可能会面临监管罚款、声誉受损和数据盗窃的重大风险。

本文来自作者投稿,版权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/zixun/47888.html